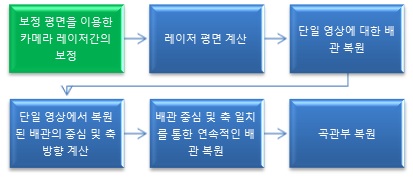

Abstract

맞춤형 신발을 제작하기 위해서는, 사용자의 정밀한 발 형상 데이터가 필요하다. 발 형상 데이터를 획득하기 위해 주로 3차원 족부 스캐너를 사용한다. 시중에 공개된 3차원 족부 스캐너들은 일반적으로 카메라와 라인 레이저로 구성된 3D 센서가 선형 이동을 하며 스캔한다. 선형 이동의 특성상 하나의 3D 센서로 족부의 모든 표면을 스캔할 수 없다. 따라서 여러 개의 3D 센서를 족부 다방면에 배치하여 스캔한다. 센서의 수가 늘어남에 따라 장치의 전체 가격이 높아지는 단점이 있다. 따라서 본 연구는 회전 3D 센서를 이용한 회전 방식의 3차원 족부 스캐너를 연구한다. 회전 이동하는 하나의 3D 센서로 족부의 모든 측면을 스캔할 수 있어, 보다 적은 양의 센서로 족부 전체의 스캔이 가능하다.

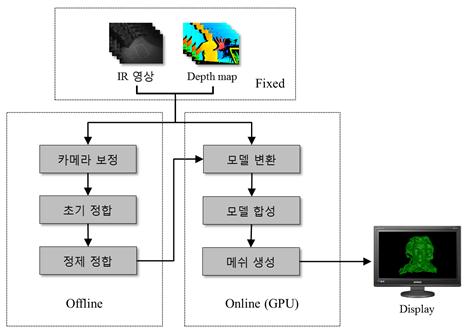

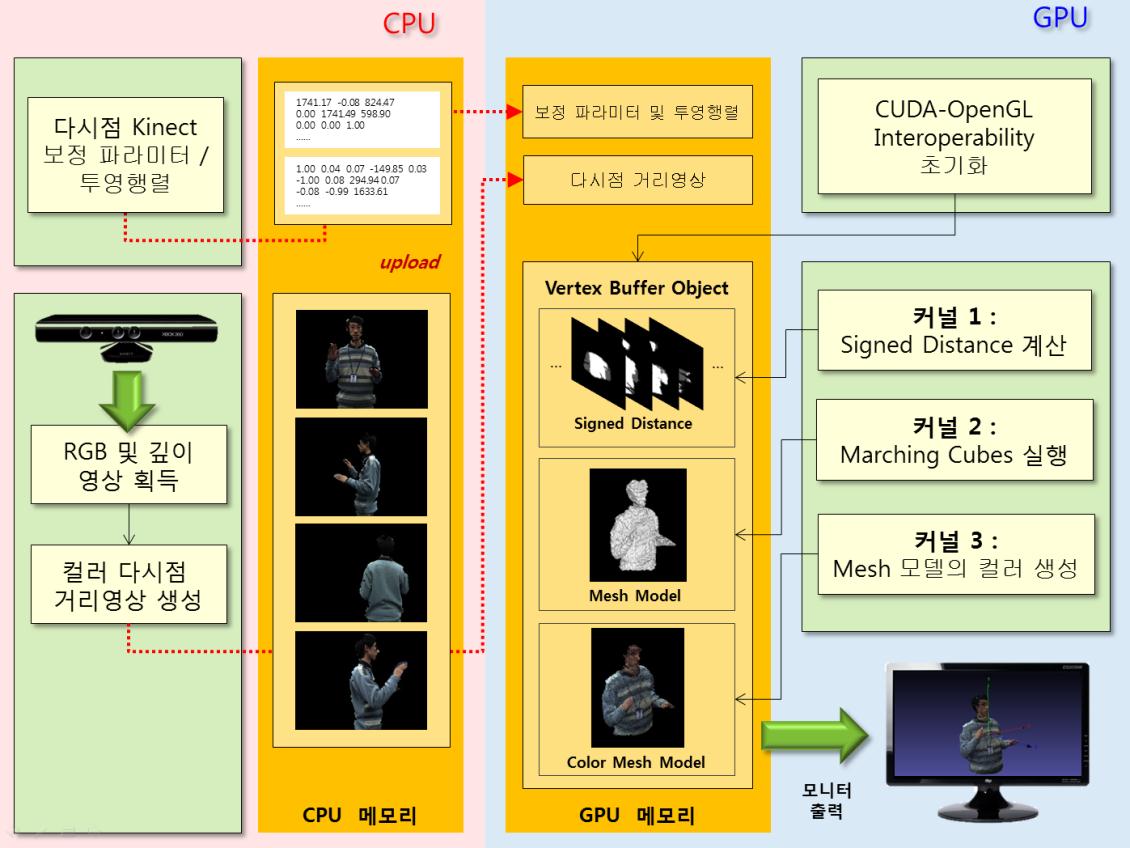

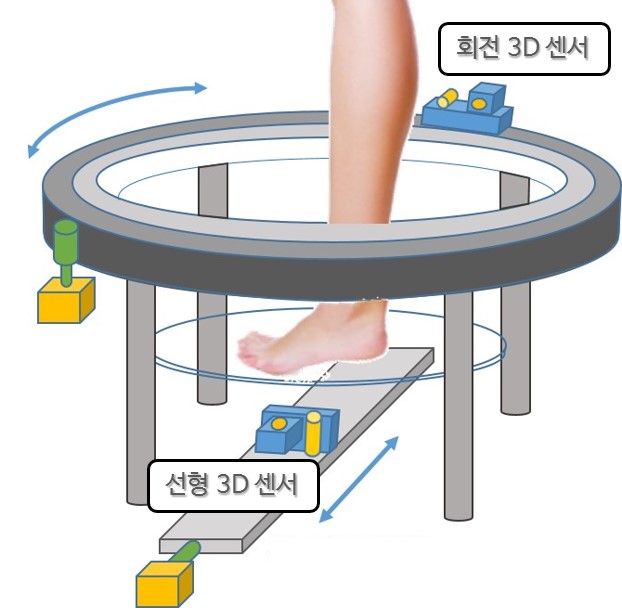

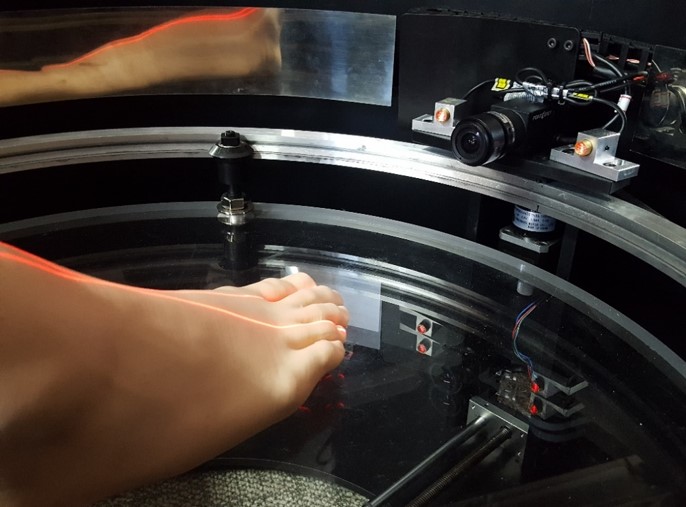

장치 구성

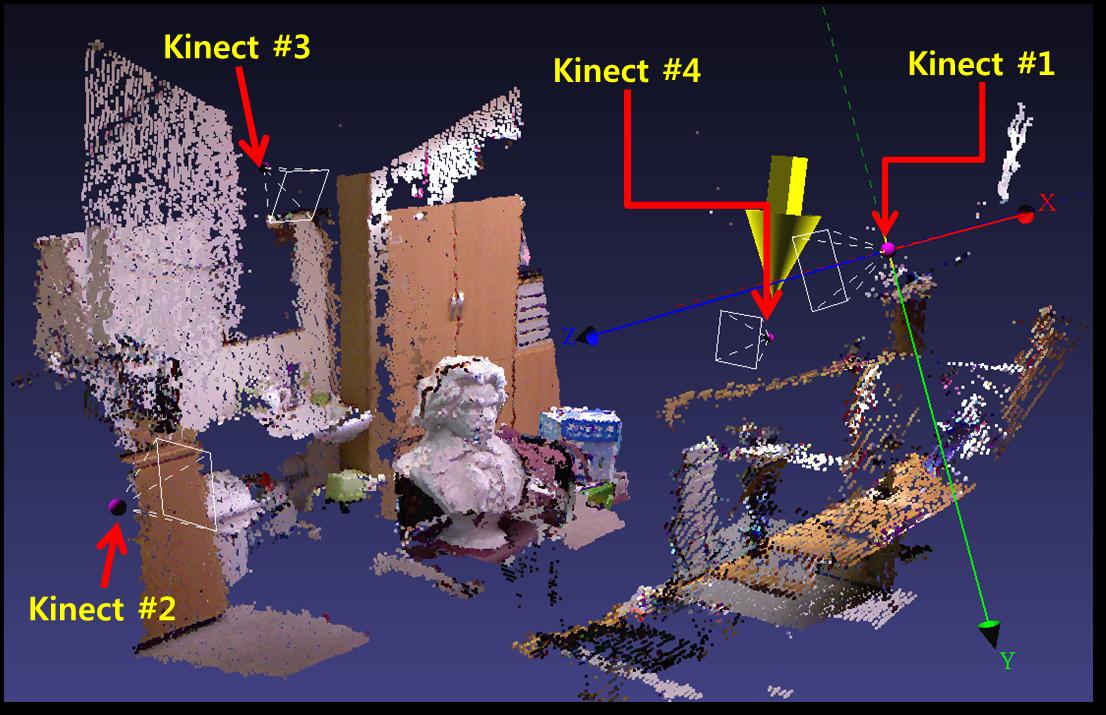

회전 이동을 할 수 있게 스캐너는 원통 형태이며, 회전 이동을 위한 회전 스테이지와 선형 이동을 위한 선형 스테이지로 구성되어 있다. 회전 3D 센서는 회전 스테이지를 따라 회전 이동하며 족부 측면을 스캔한다. 선형 3D 센서는 선형 스테이지를 따라 선형 이동하며 족부 바닥을 스캔한다.

3D 센서 구성

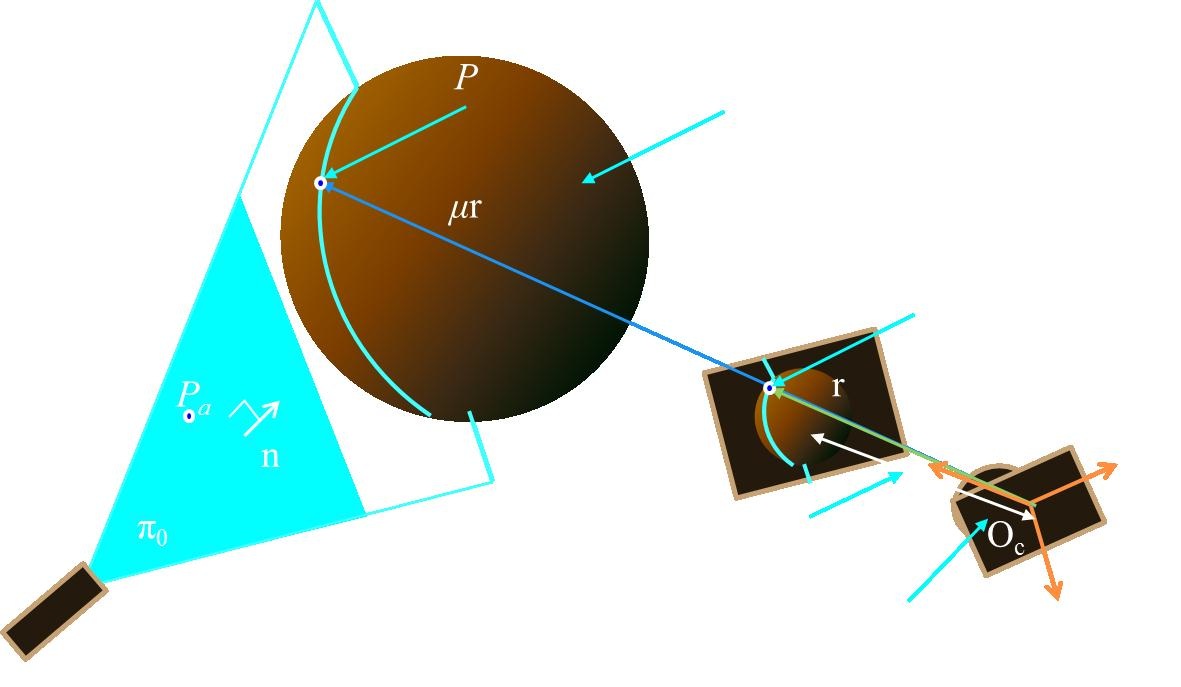

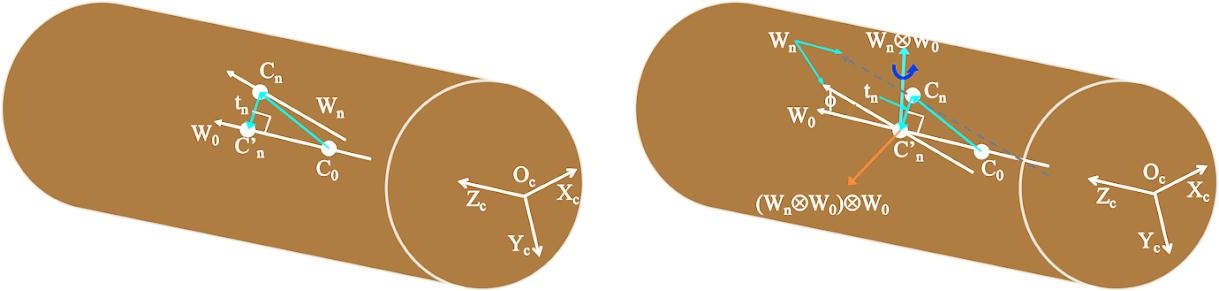

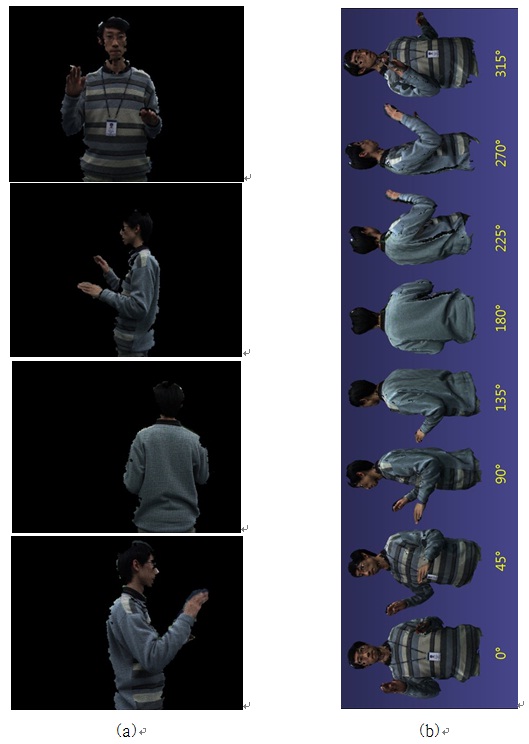

일반적인 3D 센서는 하나의 라인 레이저와 카메라로 구성되어 있다. 하지만 해당 센서를 회전 이동에 사용할 경우 스캔 과정에서 족부의 표면이 지속적으로 변화하여 많은 폐색 현상(Occlusion)이 발생한다. 이러한 문제를 해결하기 위해 두 개의 라인 레이저와 하나의 카메라로 회전 3D 센서를 구성한다. 하나의 라인 레이저가 족부 표면에 의해 폐색되더라도 이전의 위치에서 다른 라인 레이저로 폐색 영역의 스캔이 가능하여, 전체적인 폐색 현상을 줄일 수 있다.

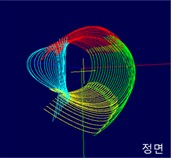

획득 영상

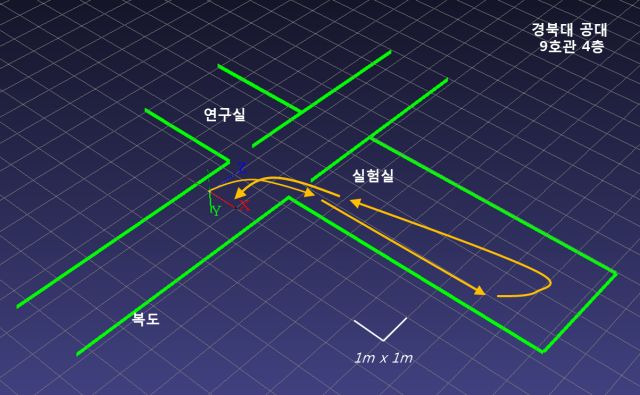

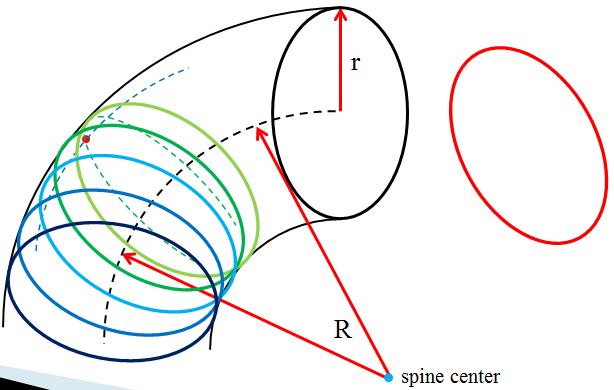

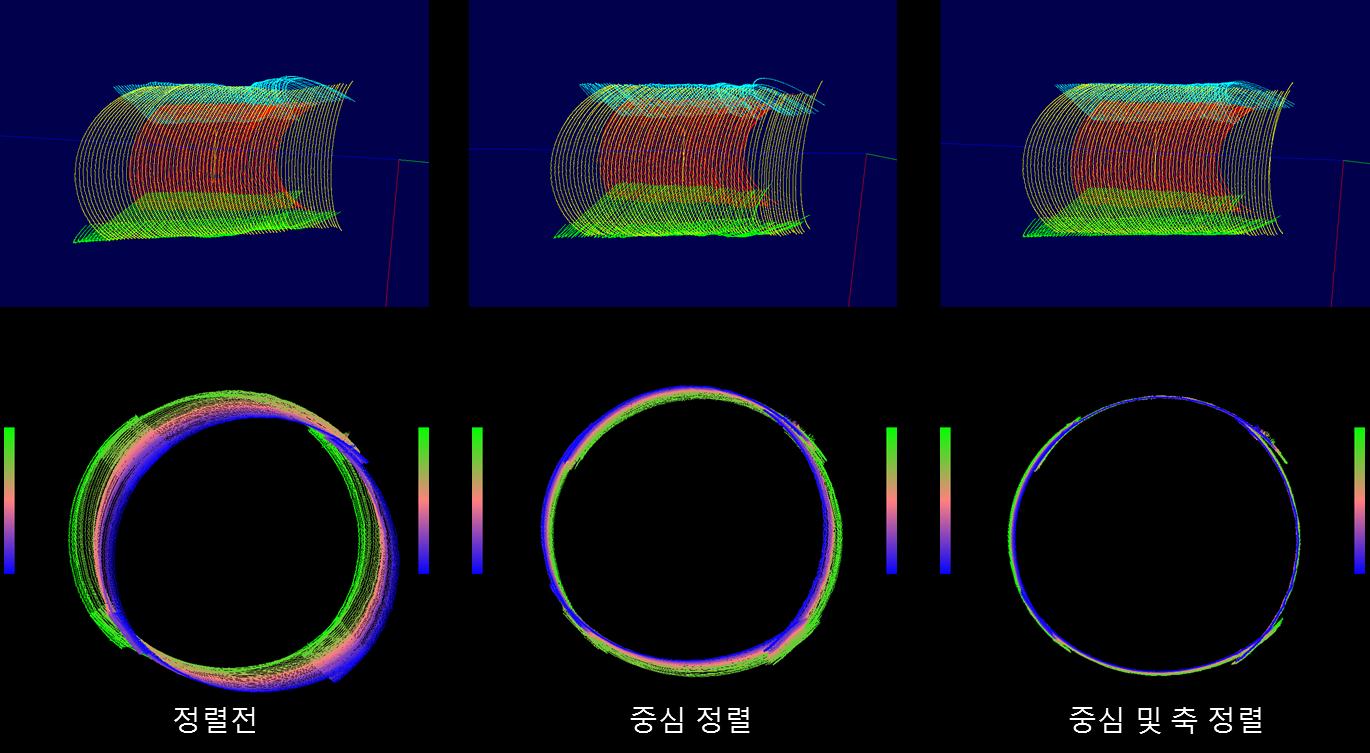

스캔 결과